В какой момент начинается мобильная фотография на камеру смартфона: с нажатия виртуальной кнопки затвора или с начала кнопки фокусировки? Правильный ответ – с момента запуска приложения Камера.

Что такое стекинг?

Как только вы увидели изображение на экране телефона, значит камера уже снимает, постоянно и непрерывно. Причем ничего “не выбрасыватся”: часто фото после нажатия кнопки затвора берется из буфера обмена, а часть еще доснимается до улучшения итогового качества картинки.

Улучшение снимка вы заметите, если быстро открыть галерею после фотографирования – изображение еще будет преображаться и “допиливаться”.

А увидеть работу постоянно работающего буфера можно, делая live фотографии. Когда кроме главного снимка сохраняются фото до нажатия затвора и после. В итоге мы получаем ролик с небольшим фреймрейтом.

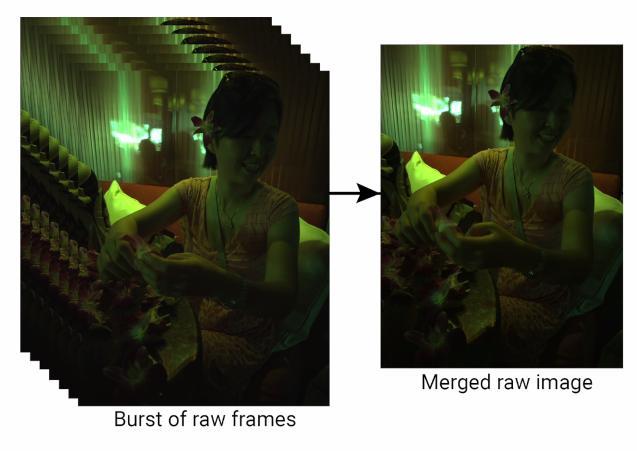

Технология склеивания огромного количества снимков называется стекингом. Это и есть та самая мобильная вычислительная фотография, за которой скрываются маркетинговые слова – нейросети и алгоритмы, которые часто многие не понимают. В этой статье попробуем разобраться в разных алгоритмах.

Стекинг – это наложение нескольких фото друг на друга.

И здесь главное понимать, все эти алгоритмы призваны решить одну фундаментальную проблему – размер сенсора камер смартфона, который физически не может быть большим, по сравнению с обычной зеркальной камерой.

Поэтому в работу вступают алгоритмы и софт.

Стекинг по экспозиции (HDR)

Стекинг по экспозиции – это технология HDR. Множество фотографий от самой темной до самой светлой получены с разной выдержкой и затем склеены в одну.

Поэтому в сложных по экспозиции фотографиях и света не выбиты, и в тенях есть информация.

И если HDR позволил получать широкий динамический диапазон, то с ночными фотографиями ничего не вышло. И тут на помощь приходит HDR+ (стекинг по времени).

Стекинг по времени (HDR+ и Night Sight)

Здесь важно понимать, что “ночной режим” съемки – это не длинная выдержка, как мы привыкли думать из фотографирования на зеркалки. В таком случае мы бы получили вот такое изображение с 3 основными проблемами: размытие (невозможно стоять неподвижно долгое время), шум, отсутствие деталей в светах и тенях.

А с технологией HDR+ снимок получаем намного лучше. Всех описанных выше проблем там нет.

Технология HDR+ делает до 15 фотографий на короткой выдержке, собирая из в RAW файл, накладывая друг на друга. Тем самым появляется информация в тенях и ликвидируются пересветы, а из-за короткой выдержки не появляется смазывание.

При этом методе есть только один минус – баланс белого. Фотографии получаются или желтыми, или зелеными. Проблема решена через технологию Night Sight.

Нейросети скормили кучу фотографий, чтобы научить ее на получаемом фото накладывать нужный фильтр. По сути делать примитивную, но очень полезную цветокоррекцию.

Стекинг по движению (Super Res Zoom и Deep Fusion)

Делая панорамные фотографии, задействуется технология стекинга по движению. При этом снимается не видео, а склеиваются десятки фотографий в одну с большим разрешением.

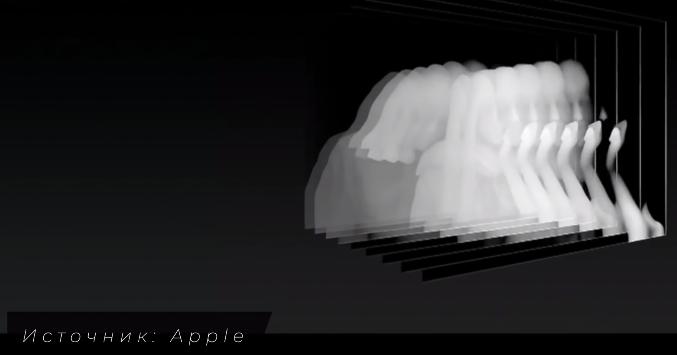

А еще к стекингу по движению относится микротряска рук.

Технология Super Res Zoom у Google, или Deep Fusion и Apple, благодаря получению смещающихся из-за микротряски фотографий дают больше информации о цвете каждого пикселя.

Благодаря этому уменьшаются шумы, увеличивается резкость и разрешение, при этом физическое число мегапикселей матрицы остается неизменным.

Это касается и получения фото с приближением.

Стекинг по фокусу (карты глубины и Lidar)

Со стекингом по фокусу все очень просто. Смартфон делает фото объекта, на который вы навелись, затем за ним, потом перед ним. И происходит склеивание 3 фотографий.

Таким образом решаются 2 проблемы. На макрофотографиях объект получается резким, а на фотоаппаратах нужно жертвовать светом, прикрывая диафрагму.

В режиме “Портрет” на уже полученной фотографии фон можно сделать четче или более размытым только за счет стекинга по фокусу. А еще при создании портретной фотографии с эффектом Боке одним лишь стекингом по фокусу не обойтись.

Используются карты глубины. Раньше они создавались двумя линзами, как на iPhone 7+, а сейчас и на одной линзе по двум кадрам, сдвинутых на 1 субпиксель.

С приходом LiDAR стало еще проще. Карта глубины строится за счет посылания фотонов света и измерений точных расстояний до предметов в радиусе 5 метров.

Эта технология точнее, но требует дополнительный модуль на борту смартфона. Правда, и сфер использования больше: дополненная реальность, более точное измерение расстояний, более быстрый и точный автофокус в условиях низкой освещенности (читайте обзор iPhone 12 Pro).

RAW в смартфонах (Apple Pro RAW)

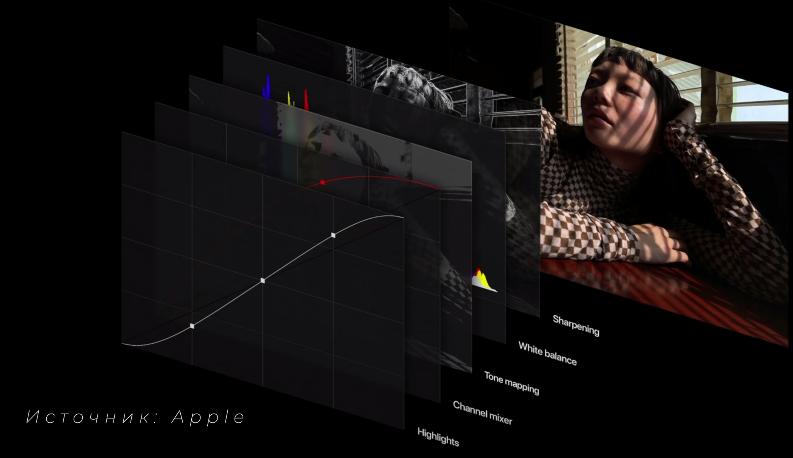

Итак, смартфон у нас делает потрясающие стекинги, применяет очень хитрые алгоритмы, сильно улучшающие качество изображения. Но при этом итоговая картинка упаковывается в сжатый jpeg файл, который особо не отредактируешь в том же Photoshop.

В 2020 году iPhone научились делать фотографии RAW в формате dmg. Сюда упаковываются карту глубин, полезные маски и результаты различных хитрых режимов.

В результате с RAW файлами с iPhone работать в фоторедакторе уже сильно приятнее, чем с пожатым jpeg.

Подробнее про Apple Pro RAW читайте здесь.

Будущее мобильной фотографии

Есть ощущение, что мы близки к пределу мобильной фотографии по софтверной и хардверной части. Что будет дальше, пока непонятно.

Может, мобильное приложение научат получать и накладывать на ваши снимки куски высококачественных изображений из банков фотографий с типовыми фонами, зданиями, предметами, исправляя недостатки маленького сенсора. А может появится и дополненная реальность, а зеркальные фотокамеры канут в небытие.

По материалам Apple, Google, iFixit, ProTech, Keiichi Matsuda.