Apple – это та компания, которая для своих пользователей в плане безопасности делает действительно много. В AppStore мы видим минимальное число нежелательных приложений, сторонние разработчики максимально ограничиваются в доступе к нашему контенту, а нам, в свою очередь, предоставлены инструменты для самостоятельного распоряжения собственным контентом и той информацией, которой мы хотим поделиться.

Новая программа безопасности

На офиц. сайте Apple опубликовала новую программу под названием “Расширенная защита детей”. Это комплекс мер, состоящий из 3х частей:

- Безопасность при общении в iMessage.

- Установление фактов сексуального насилия над детьми.

- Обучение Siri в выдаче по таким вопросам.

Давайте пробежимся по каждой части.

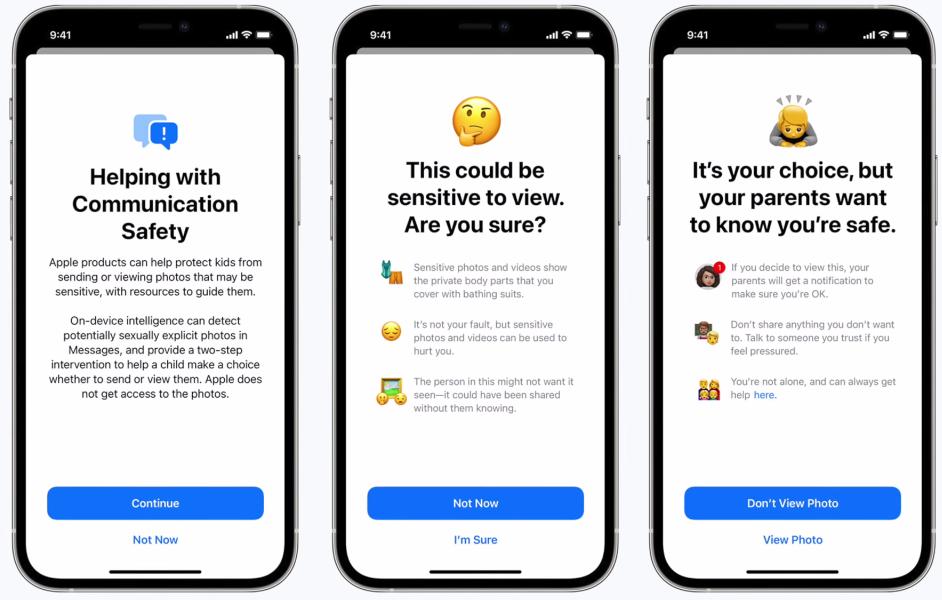

Часть 1:Безопасность в iMessage

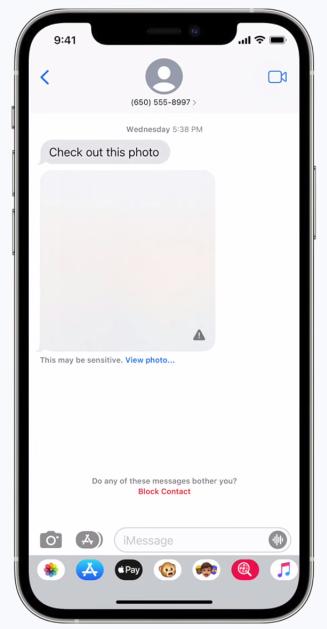

Приложение iMessage (Сообщения) получит новую функцию “Безопасная связь”. Она позволяет предупредить детей или их родителей при получении или отправке откровенных фотографий сексуального характера.

При получении откровенных фото алгоритм машинного обучения распознает его и “заблюрит”. Ребенок будет предупрежден, а если попытается открыть, родители получат уведомление.

Функция, бесспорно, полезная. Другое дело, что iMessage – это не такой популярный инструмент, как социальные сети. И во-вторых, насколько часто вам будут писать незнакомцы через iMessage? Ведь в таком случае они должны знать ваш номер телефона.

Часть 2: Обучение Siri

Голосовой помощник Siri “натренируют” на выдачу грамотных результатов. Если например, ребенок или взрослый интересуется, как обратиться за специализированной помощью. Или например, они захотят подать заявление о насилии над детьми или эксплуатации.

Функция довольно полезная. Вы будете меньше ошибаться в поисковиках, и будет меньше вероятность попасть на нежелательную выдачу.

Часть 3: CSAM

CSAM (Child Sexual Abuse Material) – материалы сексуального насилия над детьми.

Есть такая некоммерческая организация “Национальный центр пропавших и эксплуатируемых детей” (сайт missingkids.org), которая работает в сотрудничестве с правоохранительными органами США.

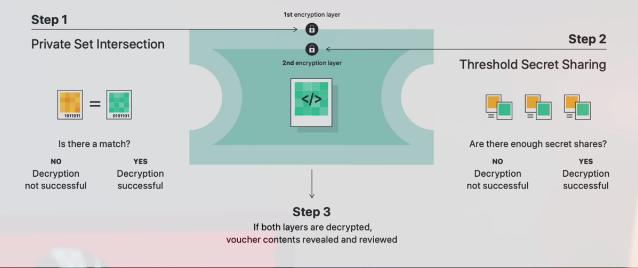

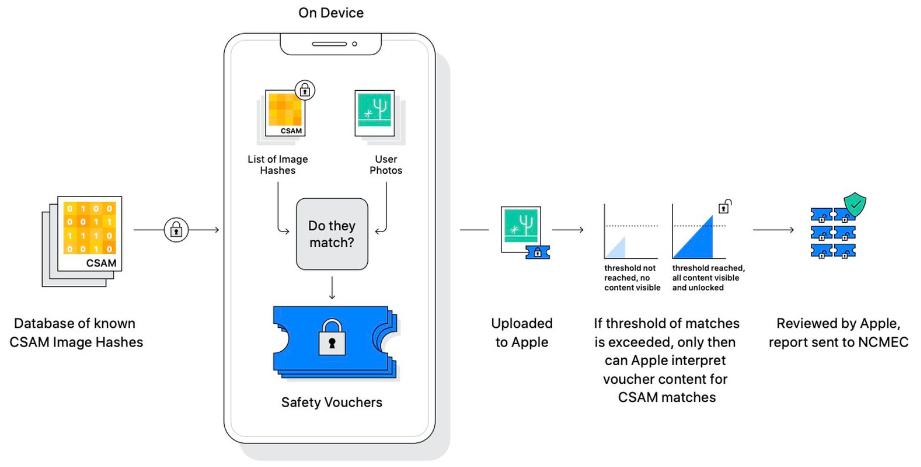

На основе фотографий с пропавшими детьми будет создаваться база с хеш-функциями (кодом).

Хеш-функция – это алгоритм преобразования массива данных ( в нашем случае это будут изображения) в код.

Дальше этот код собирается в большую базу данных и передается Apple. А Apple, в свою очередь, сможет отсканировать ваши фотографии и найти совпадения.

Все фото пользователя обычно хранятся в устройстве или на iCloud. По идее, Apple должна сканировать и то, и другое. Но для того, чтобы отсканировать фотографии в iCloud, необходимы мощности, а это дополнительные затраты. Да и как добраться до ваших устройств?

И тут придумана гениальная технология Neural hash. Фотографии перед загрузкой в iCloud будут просканированы непосредственно вашим iPhone, потом прохешированы. Полученный файлик будет заскриптован и прикреплен к фото. Затем уже эта фотография будет загружаться в облачное хранилище.

Т.е. все фото в iCloud уже проанализированы, в том числе и фотографии на вашем iPhone, при помощи мощности вашего же устройства.

Дальше вступает в работу специальный алгоритм. Как только будет совпадение базы данных сайта пропавших детей с базой данных вашей медиатеки, и наберется какая-то критическая масса этих совпадений, данные будут переданы Apple, проанализированы (в частном порядке), далее переданы в “Национальный центр пропавших и эксплуатируемых детей” и в полицию.

При этом ваша учетная запись Apple ID со всеми данными будет заблокирована. Конечно, у вас будет право подать апелляцию, но все равно открытых вопросов остается еще много.

Например, как специалисты Apple будут повторно проверять работу алгоритма? Единственный способ – проанализировать фото, которые к ним придут. А что если там нет совпадений, но есть мои личные фотографии, например, моего ребенка?

Тут вы должны знать, что другие крупные компании (Microsoft, Google, Facebook, Twitter) уже анализирует интернет-пространство на наличие такого контента, чтобы потом его банить. А компания Apple решила анализировать именно вашу медиатеку, расположенную на вашем устройстве при помощи мощностей вашего же устройства.

Запустится процесс в будущих обновлениях. Причем iMessage и Siri будут бороться с запрещенным контентом, только начиная с версии iOS 15, iPadOS 15 и macOS Monterey. А вот алгоритм поиска на устройстве будет работать только на iOS и iPadOS устройствах, причем версия прошивки официально не указана. А это значит, что обновление может “прилететь” на любую версию iOS в любой момент.

Пока данный алгоритм будет работать только на территории США, но это только пока. Я абсолютно не против, чтобы крупные компании анализировали сеть, искали “запрещенку”, банили ее и разоблачали злоумышленников. Но когда копаются в моем личном устройстве – это совсем другое.

Банально все злоумышленники после этой новости скинут всю запрещенную инфу на свою флешку или на ПК, и будут там ее и просматривать. А миллионы устройств по всему миру будут сканироваться.